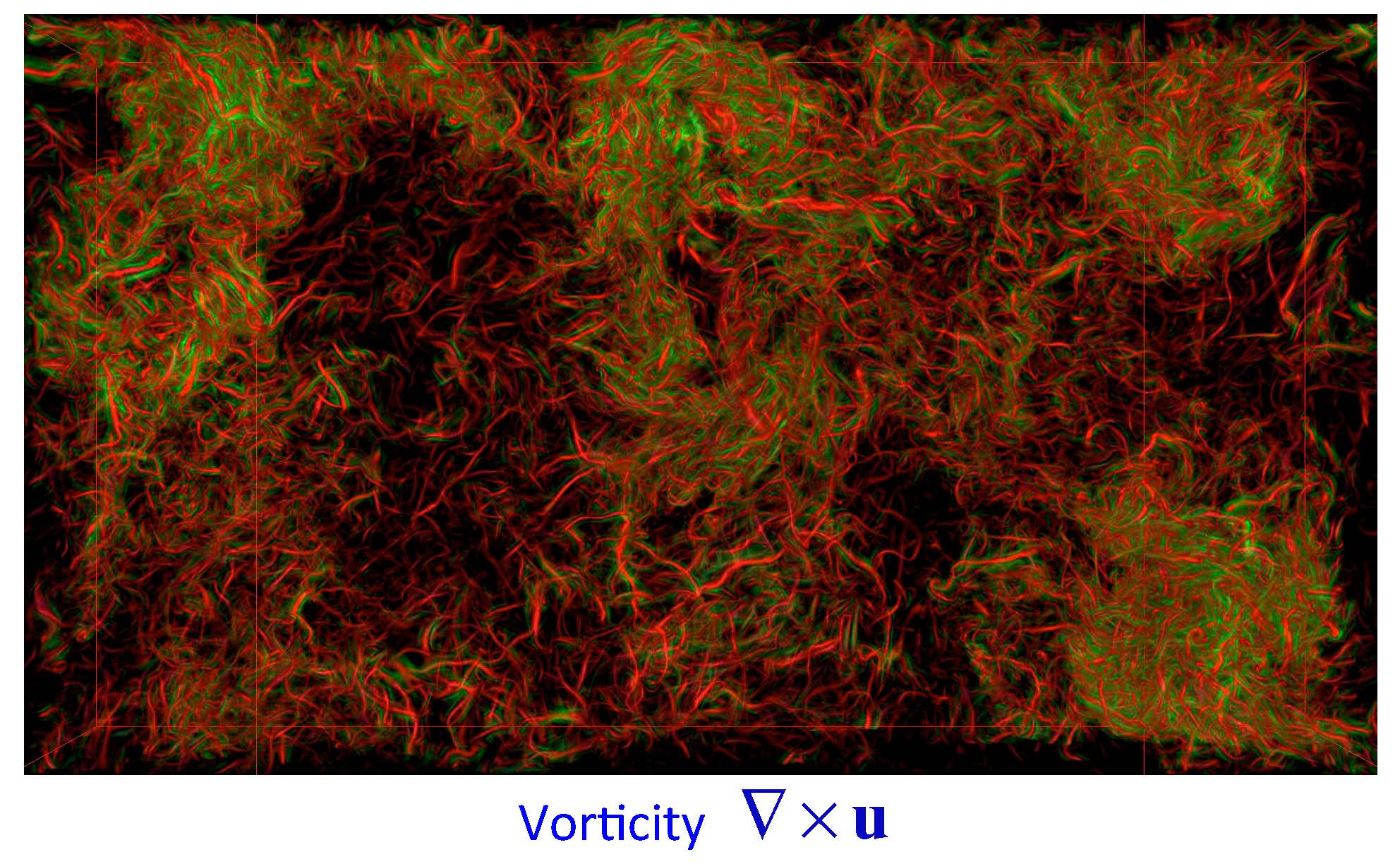

Simulación de turbulencia de fluidos accesible a través de SciServer. Imagen: Kai Buerger. Fuente: TU Munchen/Johns Hopkins Turbulence Databases.

Dos iniciativas TIC están copando los titulares sobre tecnología en los últimos tiempos, con la promesa de revolucionar la informática, la práctica empresarial, la educación y la mayoría de las áreas del conocimiento en las que uno pueda pensar.

Por un lado, explica en su web Imdea Networks Institute, instituto de investigación de la Comunidad de Madrid, los datos masivos o datos a gran escala (Big Data) son un paradigma emergente para la gestión de cantidades ingentes de información más allá de las capacidades de la tecnología que soporta las bases de datos tradicionales.

Por otro lado, la computación en la nube (Cloud Computing) surge como paradigma en los sistemas de computación distribuida, cuya meta es ofrecer el software como un servicio a través de Internet. La computación en la nube ofrece un modelo de entrega ágil y una infraestructura altamente escalable para soportar las demandas de almacenamiento y cómputo de las tecnologías de grandes datos.

Ambas tecnologías convergen para ofrecer un inmenso surtido de datos que explorar y de los que obtener análisis significativos, así como una creciente gama de servicios y recursos con aplicaciones en cualquier campo que se vea afectado por la innovación y el desarrollo de las TIC.

Tanto el cloud computing como el Big Data maduran rápidamente y su uso se está generalizando, pero se necesita, explica Imdea, un esfuerzo decidido para crear un entorno holístico en el que ambos puedan prosperar y desarrollar todo su potencial. El ambicioso objetivo científico del proyecto Cloud4BigData - puesto en marcha recientemente por Imdea, la Universidad Politécnica de Madrid y la Universidad Rey Juan Carlos - es facilitar la convergencia de las tecnologías Big Data con su infraestructura cloud subyacente, para lograr altos niveles de eficiencia, flexibilidad, escalabilidad, alta disponibilidad, calidad de servicio, facilidad de uso, seguridad y privacidad.

Combinación

Cloud4BigData abordará sin ambages los actuales inconvenientes y deficiencias del Big Data y del Cloud Computing, sacando partido también de sus fortalezas. Desde la gestión segura al procesamiento eficiente de los datos, el proyecto tiene como objetivo combinar e integrar tecnologías diferenciadas y especializadas en una sola plataforma unificada.

El proyecto también demostrará su competencia en áreas de aplicación emergente con requisitos muy exigentes que demandan tecnologías cloud y Big Data, tales como las tecnologías máquina a máquina (machine-to-machine), el Internet de las cosas (IoT – Internet of Things), las tecnologías inteligentes o smart (como la red eléctrica inteligente, Smart Grid; las ciudades inteligentes, Smart cities; el transporte inteligente, Smart transport; etc.), así como en áreas tradicionales de aplicación, tales como la banca, la telefonía, la comunicación multimedia, las simulaciones distribuidas, etc., que demandan funcionalidades más allá de las capacidades actuales de las tecnologías Big Data.

Cloud4BigData está financiado por la Comunidad de Madrid, a través del Programa de Actividades de I+D entre grupos de investigación en Tecnologías 2013, cofinanciado con Fondos Estructurales de la Unión Europea. Comenzó el pasado octubre del 2014 y concluirá en septiembre de 2018.

Por un lado, explica en su web Imdea Networks Institute, instituto de investigación de la Comunidad de Madrid, los datos masivos o datos a gran escala (Big Data) son un paradigma emergente para la gestión de cantidades ingentes de información más allá de las capacidades de la tecnología que soporta las bases de datos tradicionales.

Por otro lado, la computación en la nube (Cloud Computing) surge como paradigma en los sistemas de computación distribuida, cuya meta es ofrecer el software como un servicio a través de Internet. La computación en la nube ofrece un modelo de entrega ágil y una infraestructura altamente escalable para soportar las demandas de almacenamiento y cómputo de las tecnologías de grandes datos.

Ambas tecnologías convergen para ofrecer un inmenso surtido de datos que explorar y de los que obtener análisis significativos, así como una creciente gama de servicios y recursos con aplicaciones en cualquier campo que se vea afectado por la innovación y el desarrollo de las TIC.

Tanto el cloud computing como el Big Data maduran rápidamente y su uso se está generalizando, pero se necesita, explica Imdea, un esfuerzo decidido para crear un entorno holístico en el que ambos puedan prosperar y desarrollar todo su potencial. El ambicioso objetivo científico del proyecto Cloud4BigData - puesto en marcha recientemente por Imdea, la Universidad Politécnica de Madrid y la Universidad Rey Juan Carlos - es facilitar la convergencia de las tecnologías Big Data con su infraestructura cloud subyacente, para lograr altos niveles de eficiencia, flexibilidad, escalabilidad, alta disponibilidad, calidad de servicio, facilidad de uso, seguridad y privacidad.

Combinación

Cloud4BigData abordará sin ambages los actuales inconvenientes y deficiencias del Big Data y del Cloud Computing, sacando partido también de sus fortalezas. Desde la gestión segura al procesamiento eficiente de los datos, el proyecto tiene como objetivo combinar e integrar tecnologías diferenciadas y especializadas en una sola plataforma unificada.

El proyecto también demostrará su competencia en áreas de aplicación emergente con requisitos muy exigentes que demandan tecnologías cloud y Big Data, tales como las tecnologías máquina a máquina (machine-to-machine), el Internet de las cosas (IoT – Internet of Things), las tecnologías inteligentes o smart (como la red eléctrica inteligente, Smart Grid; las ciudades inteligentes, Smart cities; el transporte inteligente, Smart transport; etc.), así como en áreas tradicionales de aplicación, tales como la banca, la telefonía, la comunicación multimedia, las simulaciones distribuidas, etc., que demandan funcionalidades más allá de las capacidades actuales de las tecnologías Big Data.

Cloud4BigData está financiado por la Comunidad de Madrid, a través del Programa de Actividades de I+D entre grupos de investigación en Tecnologías 2013, cofinanciado con Fondos Estructurales de la Unión Europea. Comenzó el pasado octubre del 2014 y concluirá en septiembre de 2018.

'Big data' y ciencia

Otro proyecto de big data, SciServer, apoyado por la National Science Foundation (NSF) estadounidense, tiene como objetivo construir un ecosistema flexible y a largo plazo que proporcione a los científicos acceso a los enormes conjuntos de datos de observaciones y simulaciones.

Alex Szalay, de la Universidad Johns Hopkins, es el investigador principal del proyecto, de cinco años previstos de duración, y el arquitecto del Archivo Científico del Sloan Digital Sky Survey (SDSS), un proyecto que pretende cartografiar el universo entero. De éste último es de donde surgió la idea SciServer, explica Szalay.

"Cuando el SDSS se inició en 1998, los astrónomos tenían datos de menos de 200.000 galaxias", explica Ani Thakar, astrónomo de la Universidad Johns Hopkins, que es parte del equipo SciServer. "Cinco años después de comenzar SDSS, teníamos cerca de 200 millones de galaxias en nuestra base de datos. Hoy en día, los datos de SDSS supera los 70 terabytes, que cubren más de 220 millones de galaxias y 260 millones de estrellas."

El equipo de la Johns Hopkins creó varias herramientas en línea para acceder a los datos de SDSS. Por ejemplo, en el sitio SkyServer, cualquier persona puede navegar a través del cielo, obtener información detallada acerca de las estrellas o buscar objetos utilizando múltiples criterios. El sitio también incluye actividades educativas listas para hacer en clase que permiten a los estudiantes aprender ciencia a partir de datos de última generación.

Para análisis más avanzados, crearon Casjobs, donde se pueden ejecutar consultas de hasta ocho horas y almacenar los resultados en una base de datos personal. Con cada nueva herramienta, la comunidad de usuarios creció, lo que llevó a realizar nuevos descubrimientos científicos.

Problemas

Sin embargo, para que todos estos datos sean analizables hace falta que los formatos, los metadatos y el acceso a los mismos tenga cierto mantenimiento, algo que se complica cuando los investigadores se van retirando y los formatos se quedan obsoletos. El equipo SciServer ha pasado las últimas dos décadas abordando estos problemas, primero en astronomía y luego en otras áreas de la ciencia.

Liderados por Szalay, el equipo comenzó a trabajar en SciServer en 2013 con financiación de la NSF. Previsto para ser lanzado al mercado en varias etapas durante los próximos cuatro años, SciServer ofrecerá importantes beneficios a la comunidad científica mediante la ampliación de la infraestructura desarrollada para los datos de SDSS a muchas otras áreas de la ciencia.

"Nuestro enfoque en el diseño de SciServer es llevar el análisis a los datos. Esto significa que los científicos puedan buscar y analizar grandes volúmenes de datos sin necesidad de descargar terabytes de datos, lo que resulta en tiempos de procesamiento mucho más rápidos", explica Szalay en la nota de prensa de la NSF. "Eso también hace que sea mucho más fácil comparar y combinar conjuntos de datos, permitiendo a los investigadores descubrir nuevas y sorprendentes conexiones entre ellos."

Szalay y su equipo están trabajando en estrecha colaboración con colegas investigadores para concretar casos de uso en el mundo real para asegurarse de que el sistema sea lo más útil posible para los científicos sobre el terreno. De hecho, ya se han logrado avances significativos en dos campos: la ecología del suelo y la dinámica de fluidos.

Para ayudar a aliviar la carga de los investigadores, el equipo desarrolló SciDrive, un sistema de almacenamiento de datos en la nube para datos científicos que permite a los científicos subir y compartir datos utilizando una interfaz similar a Dropbox. La interfaz lee automáticamente los datos en una base de datos, y uno puede buscar en línea y hacer una correlación cruzada con otras fuentes de datos.

Ciencia ciudadana

SciServer ampliará esta capacidad a un nuevo proyecto de ciencia ciudadana llamada Gluseen (Red Global Urbana Educacional y Ecológica sobre el Suelo), cuyo objetivo es recopilar datos en todo el mundo sobre la ecología del suelo en una variedad de condiciones climáticas. "Nuestro enfoque será útil para muchas otras áreas de la ciencia, donde los conjuntos de datos gestionados por investigadores individuales deberán combinarse con grandes conjuntos de datos disponibles para el público", explica Szalay.

SciServer también tiene una importante iniciativa en marcha para desarrollar un "laboratorio numérico abierto" para el acceso y procesamiento de grandes bases de datos de simulación. En colaboración con el grupo de Simulación de Turbulencias en de Universidad Johns Hopkins, están desarrollando un sistema piloto para integrar conjuntos de datos y procesos de trabajo de de simulación de turbulencias en SciServer.

En el futuro, el proyecto se extenderá a la genómica - donde los investigadores deben correlacionar de forma cruzada petabytes de datos para entender genomas enteros - y la conectómica - la exploración de las conexiones celulares a través de toda la estructura del cerebro-. Estas colaboraciones se extenderán por un período de cinco años, hasta 2018.

Otro proyecto de big data, SciServer, apoyado por la National Science Foundation (NSF) estadounidense, tiene como objetivo construir un ecosistema flexible y a largo plazo que proporcione a los científicos acceso a los enormes conjuntos de datos de observaciones y simulaciones.

Alex Szalay, de la Universidad Johns Hopkins, es el investigador principal del proyecto, de cinco años previstos de duración, y el arquitecto del Archivo Científico del Sloan Digital Sky Survey (SDSS), un proyecto que pretende cartografiar el universo entero. De éste último es de donde surgió la idea SciServer, explica Szalay.

"Cuando el SDSS se inició en 1998, los astrónomos tenían datos de menos de 200.000 galaxias", explica Ani Thakar, astrónomo de la Universidad Johns Hopkins, que es parte del equipo SciServer. "Cinco años después de comenzar SDSS, teníamos cerca de 200 millones de galaxias en nuestra base de datos. Hoy en día, los datos de SDSS supera los 70 terabytes, que cubren más de 220 millones de galaxias y 260 millones de estrellas."

El equipo de la Johns Hopkins creó varias herramientas en línea para acceder a los datos de SDSS. Por ejemplo, en el sitio SkyServer, cualquier persona puede navegar a través del cielo, obtener información detallada acerca de las estrellas o buscar objetos utilizando múltiples criterios. El sitio también incluye actividades educativas listas para hacer en clase que permiten a los estudiantes aprender ciencia a partir de datos de última generación.

Para análisis más avanzados, crearon Casjobs, donde se pueden ejecutar consultas de hasta ocho horas y almacenar los resultados en una base de datos personal. Con cada nueva herramienta, la comunidad de usuarios creció, lo que llevó a realizar nuevos descubrimientos científicos.

Problemas

Sin embargo, para que todos estos datos sean analizables hace falta que los formatos, los metadatos y el acceso a los mismos tenga cierto mantenimiento, algo que se complica cuando los investigadores se van retirando y los formatos se quedan obsoletos. El equipo SciServer ha pasado las últimas dos décadas abordando estos problemas, primero en astronomía y luego en otras áreas de la ciencia.

Liderados por Szalay, el equipo comenzó a trabajar en SciServer en 2013 con financiación de la NSF. Previsto para ser lanzado al mercado en varias etapas durante los próximos cuatro años, SciServer ofrecerá importantes beneficios a la comunidad científica mediante la ampliación de la infraestructura desarrollada para los datos de SDSS a muchas otras áreas de la ciencia.

"Nuestro enfoque en el diseño de SciServer es llevar el análisis a los datos. Esto significa que los científicos puedan buscar y analizar grandes volúmenes de datos sin necesidad de descargar terabytes de datos, lo que resulta en tiempos de procesamiento mucho más rápidos", explica Szalay en la nota de prensa de la NSF. "Eso también hace que sea mucho más fácil comparar y combinar conjuntos de datos, permitiendo a los investigadores descubrir nuevas y sorprendentes conexiones entre ellos."

Szalay y su equipo están trabajando en estrecha colaboración con colegas investigadores para concretar casos de uso en el mundo real para asegurarse de que el sistema sea lo más útil posible para los científicos sobre el terreno. De hecho, ya se han logrado avances significativos en dos campos: la ecología del suelo y la dinámica de fluidos.

Para ayudar a aliviar la carga de los investigadores, el equipo desarrolló SciDrive, un sistema de almacenamiento de datos en la nube para datos científicos que permite a los científicos subir y compartir datos utilizando una interfaz similar a Dropbox. La interfaz lee automáticamente los datos en una base de datos, y uno puede buscar en línea y hacer una correlación cruzada con otras fuentes de datos.

Ciencia ciudadana

SciServer ampliará esta capacidad a un nuevo proyecto de ciencia ciudadana llamada Gluseen (Red Global Urbana Educacional y Ecológica sobre el Suelo), cuyo objetivo es recopilar datos en todo el mundo sobre la ecología del suelo en una variedad de condiciones climáticas. "Nuestro enfoque será útil para muchas otras áreas de la ciencia, donde los conjuntos de datos gestionados por investigadores individuales deberán combinarse con grandes conjuntos de datos disponibles para el público", explica Szalay.

SciServer también tiene una importante iniciativa en marcha para desarrollar un "laboratorio numérico abierto" para el acceso y procesamiento de grandes bases de datos de simulación. En colaboración con el grupo de Simulación de Turbulencias en de Universidad Johns Hopkins, están desarrollando un sistema piloto para integrar conjuntos de datos y procesos de trabajo de de simulación de turbulencias en SciServer.

En el futuro, el proyecto se extenderá a la genómica - donde los investigadores deben correlacionar de forma cruzada petabytes de datos para entender genomas enteros - y la conectómica - la exploración de las conexiones celulares a través de toda la estructura del cerebro-. Estas colaboraciones se extenderán por un período de cinco años, hasta 2018.

Tendencias Científicas

Tendencias Científicas

El Internet de las Cosas se propaga rápidamente

El Internet de las Cosas se propaga rápidamente  CIENCIA ON LINE

CIENCIA ON LINE