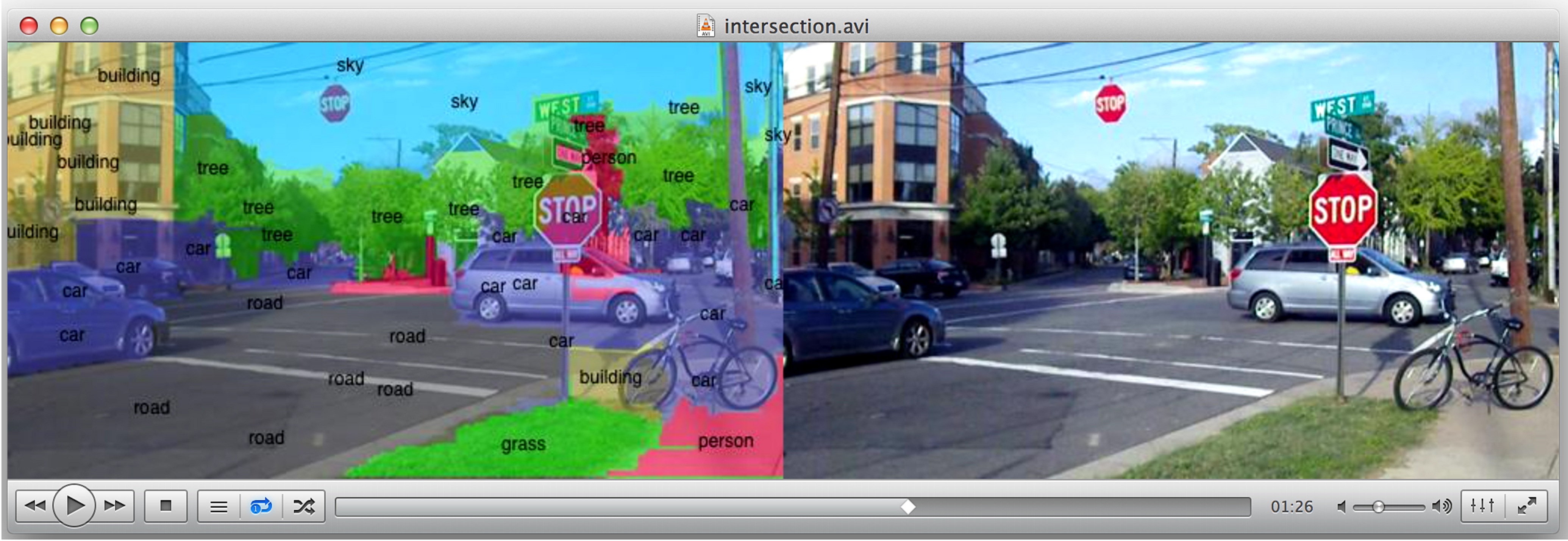

Una imagen procesada por el nuevo sistema, que incorpora palabras que describen el entorno. Fuente: Universidad de Purdue.

Investigadores de la Universidad de Purdue (Indiana, EE.UU.) están trabajando para conseguir que los teléfonos inteligentes y otros dispositivos móviles se vuelvan más inteligentes aún, es decir, comprendan e identifiquen de inmediato objetos en el campo visual de una cámara, superponiendo líneas de texto que describan los elementos del entorno. "El sistema analiza la escena y pone etiquetas a todo", explica Eugenio Culurciello, profesor asociado en la Escuela Weldon de Ingeniería Biomédica y en el Departamento de Psicología, en la nota de prensa de la Universidad.

La innovación podría encontrar aplicaciones en tecnologías de "realidad aumentada" como Google Glass, los sistemas de reconocimiento facial y los coches robóticos que se conducen solos. " Cuando le das visión a las máquinas, el cielo es el límite", bromea Culurciello.

El concepto se llama aprendizaje profundo, ya que requiere capas de redes neuronales que imitan cómo procesa la información el cerebro humano. Las empresas de Internet utilizan software de deep-learning, que permite a los usuarios buscar en la web fotos y vídeos que han sido etiquetados con palabras clave. Tal etiquetado, sin embargo, no es posible en dispositivos portátiles y ordenadores personales.

"Los algoritmos de aprendizaje profundo que pueden etiquetar vídeos e imágenes requieren una gran cantidad de cálculo, por lo que no ha sido posible hacerlo en los dispositivos móviles", explica Culurciello, que está trabajando con Berin Martini, un investigador asociado de la Universidad de Purdue, y con estudiantes de doctorado.

El grupo de investigación ha desarrollado software y hardware, y muestra cómo se pueden utilizar para habilitar un procesador de smartphone convencional para que ejecute el software. Los resultados de la investigación fueron presentados en diciembre en la conferencia Neural Information Processing Systems, celebrada en Nevada.

La innovación podría encontrar aplicaciones en tecnologías de "realidad aumentada" como Google Glass, los sistemas de reconocimiento facial y los coches robóticos que se conducen solos. " Cuando le das visión a las máquinas, el cielo es el límite", bromea Culurciello.

El concepto se llama aprendizaje profundo, ya que requiere capas de redes neuronales que imitan cómo procesa la información el cerebro humano. Las empresas de Internet utilizan software de deep-learning, que permite a los usuarios buscar en la web fotos y vídeos que han sido etiquetados con palabras clave. Tal etiquetado, sin embargo, no es posible en dispositivos portátiles y ordenadores personales.

"Los algoritmos de aprendizaje profundo que pueden etiquetar vídeos e imágenes requieren una gran cantidad de cálculo, por lo que no ha sido posible hacerlo en los dispositivos móviles", explica Culurciello, que está trabajando con Berin Martini, un investigador asociado de la Universidad de Purdue, y con estudiantes de doctorado.

El grupo de investigación ha desarrollado software y hardware, y muestra cómo se pueden utilizar para habilitar un procesador de smartphone convencional para que ejecute el software. Los resultados de la investigación fueron presentados en diciembre en la conferencia Neural Information Processing Systems, celebrada en Nevada.

Funcionamiento

Los resultados de la investigación muestran que el enfoque es aproximadamente 15 veces más eficiente que los procesadores gráficos convencionales, y es posible una mejora adicional de 10 veces más eficiencia.

"Es posible que usted tenga 10.000 imágenes en su computadora, pero en realidad no puede encontrar una imagen concreta mediante la búsqueda de una palabra clave. Digamos que usted quiere encontrar fotos de sí mismo en la playa jugando a la pelota. Ahora mismo no puede buscarlas de manera automática", explica Culurciello.

El software de aprendizaje profundo trabaja mediante la realización de procesamiento en capas. "Están combinadas de forma jerárquica", explcia Culurciello. "Para el reconocimiento facial, una capa puede reconocer los ojos, otra capa la nariz, y así sucesivamente hasta que reconoce la cara entera de una persona." Culurciello ha creado una empresa, llamada TeraDeep, para comercializar sus diseños.

Verificación facial

En esa misma línea de aprendizaje profundo, investigadores de Inteligencia Artificial de Facebook han desarrollado un software, Deepface, que distingue a unas personas de otras con un 97,25% de acierto, frente al 97,53% de los propios humanos. Además, lo consigue independientemente de variaciones en la iluminación o de si la persona de la foto está mirando a la cámara.

El nuevo software de Facebook realiza lo que los investigadores llaman verificación facial (reconoce si dos imágenes muestran la misma cara), no el reconocimiento facial (poner un nombre a una cara). Pero algunas de las técnicas utilizadas podrían aplicar a ese otro problema, señalan los investigadores, y por lo tanto podrían mejorar la precisión de Facebook al sugerir qué usuarios pueden etiquetarse en una foto recién cargada.

El error es más de una cuarta parte menor que el del software existente hasta el momento, informa MIT Technology Review. Por el momento, sin embargo, es solo una investigación en curso.

Los resultados de la investigación muestran que el enfoque es aproximadamente 15 veces más eficiente que los procesadores gráficos convencionales, y es posible una mejora adicional de 10 veces más eficiencia.

"Es posible que usted tenga 10.000 imágenes en su computadora, pero en realidad no puede encontrar una imagen concreta mediante la búsqueda de una palabra clave. Digamos que usted quiere encontrar fotos de sí mismo en la playa jugando a la pelota. Ahora mismo no puede buscarlas de manera automática", explica Culurciello.

El software de aprendizaje profundo trabaja mediante la realización de procesamiento en capas. "Están combinadas de forma jerárquica", explcia Culurciello. "Para el reconocimiento facial, una capa puede reconocer los ojos, otra capa la nariz, y así sucesivamente hasta que reconoce la cara entera de una persona." Culurciello ha creado una empresa, llamada TeraDeep, para comercializar sus diseños.

Verificación facial

En esa misma línea de aprendizaje profundo, investigadores de Inteligencia Artificial de Facebook han desarrollado un software, Deepface, que distingue a unas personas de otras con un 97,25% de acierto, frente al 97,53% de los propios humanos. Además, lo consigue independientemente de variaciones en la iluminación o de si la persona de la foto está mirando a la cámara.

El nuevo software de Facebook realiza lo que los investigadores llaman verificación facial (reconoce si dos imágenes muestran la misma cara), no el reconocimiento facial (poner un nombre a una cara). Pero algunas de las técnicas utilizadas podrían aplicar a ese otro problema, señalan los investigadores, y por lo tanto podrían mejorar la precisión de Facebook al sugerir qué usuarios pueden etiquetarse en una foto recién cargada.

El error es más de una cuarta parte menor que el del software existente hasta el momento, informa MIT Technology Review. Por el momento, sin embargo, es solo una investigación en curso.

Referencia bibliográfica:

Yaniv Taigman, Ming Yang, Marc'Aurelio Ranzato, Lior Wolf: DeepFace: Closing the Gap to Human-Level Performance in Face Verification. Conference on Computer Vision and Pattern Recognition (CVPR).

Yaniv Taigman, Ming Yang, Marc'Aurelio Ranzato, Lior Wolf: DeepFace: Closing the Gap to Human-Level Performance in Face Verification. Conference on Computer Vision and Pattern Recognition (CVPR).

Tendencias Científicas

Tendencias Científicas

El Internet de las Cosas se propaga rápidamente

El Internet de las Cosas se propaga rápidamente  CIENCIA ON LINE

CIENCIA ON LINE