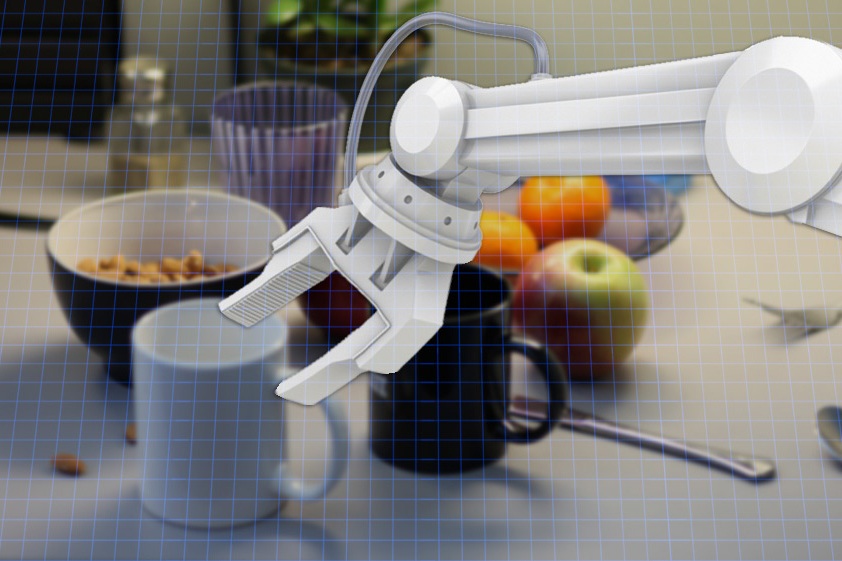

Un equipo de investigadores del Computer Science and Artificial Intelligence Laboratory del Instituto Tecnológico de Massachusetts (MIT), en EEUU, ha desarrollado un algoritmo que permite a los robots domésticos reconocer objetos y, en algunos casos, hacerlo 10 veces más rápido de lo conseguido hasta ahora.

Según informa el MIT, con este sistema lo que se pretende es que los robots domésticos se vuelvan más prácticos, para lo cual necesitan reconocer los objetos que deben manipular. Esta capacidad de reconocimiento es uno de los mayores desafíos de la inteligencia artificial actualmente.

Para el desarrollo del algoritmo, los investigadores aprovecharon la movilidad de los robots y sus entornos, relativamente estáticos. Ambos factores permiten realizar imágenes de los objetos desde múltiples perspectivas, antes de su identificación. El desafío computacional en este caso era conseguir encajar las diferentes imágenes de un mismo objeto, para concebirlas como una unidad.

Lo que hace el algoritmo es generar hipótesis a partir de las imágenes sucesivas que se le van presentando. Un número adecuado de muestras le permite alcanzar un consenso sobre lo que está “viendo”. Para que este número no sea muy alto, los científicos adoptaron una técnica simplificada de evaluación de las hipótesis.

Según informa el MIT, con este sistema lo que se pretende es que los robots domésticos se vuelvan más prácticos, para lo cual necesitan reconocer los objetos que deben manipular. Esta capacidad de reconocimiento es uno de los mayores desafíos de la inteligencia artificial actualmente.

Para el desarrollo del algoritmo, los investigadores aprovecharon la movilidad de los robots y sus entornos, relativamente estáticos. Ambos factores permiten realizar imágenes de los objetos desde múltiples perspectivas, antes de su identificación. El desafío computacional en este caso era conseguir encajar las diferentes imágenes de un mismo objeto, para concebirlas como una unidad.

Lo que hace el algoritmo es generar hipótesis a partir de las imágenes sucesivas que se le van presentando. Un número adecuado de muestras le permite alcanzar un consenso sobre lo que está “viendo”. Para que este número no sea muy alto, los científicos adoptaron una técnica simplificada de evaluación de las hipótesis.

Robots que ven gracias a las langostas

En 2013, un equipo de investigadores de las universidades británicas de Lincoln y Newcastle también consiguieron hacer que los robots “viesen”, en este caso con una herramienta informática inspirada en el particular sistema visual de insectos como la langosta.

El trabajo comenzó por entender la anatomía, las respuestas y el desarrollo de los circuitos en el cerebro de una langosta, lo que les permite detectar objetos próximos y evitarlos, tanto en vuelo como en tierra.

A partir de ahí se creó lo que los investigadores denominaron sistema de control motor estimulado visualmente (VSMC, por las siglas en inglés), para la navegación autónoma de robots. El mismo consta de dos tipos de detectores de movimiento (LGMD) y un generador de comandos sencillo.

Cada detector procesa las imágenes, cubriendo una amplia parte del campo de visión, y extrae aquellas más relevantes. Estas pistas visuales se comparan y convierten después en órdenes motoras que el robot ejecuta en tiempo real.

Robots sensibles a lo que tocan

En 2010, también investigadores del MIT consiguieron dotar a los robots de otro sentido: el tacto. En colaboración con la compañía británica Peratech, en este caso los ingenieros utilizaron una tecnología consistente en unos materiales especiales que, cuando se los toca, generan una respuesta eléctrica medible y proporcional al grado de presión que se ejerza sobre ellos.

Un circuito electrónico simple instalado dentro de los robots “interpretaba” dichas señales, para que la máquina “supiese” que la están tocando y cómo.

En esta misma línea se ha trabajado también en el marco del proyecto europeo ROBOSKIN, financiado por la UE, con el desarrollo de tecnologías de sensores y una piel artificial que permitirán crear robots mucho más "sensibles" al tacto, y que tendrán por tanto relaciones más interactivas y seguras con los humanos; así como en la Viterbi School of Engineering de la University of Southern California (USC) de Estados Unidos.

En este centro, en 2013 se desarrolló una tecnología basada en sensores especiales y en un programa informático específico, que permitió crear un robot capaz de distinguir materiales solo con tocarlos, con una capacidad de acierto del 95%.

En 2013, un equipo de investigadores de las universidades británicas de Lincoln y Newcastle también consiguieron hacer que los robots “viesen”, en este caso con una herramienta informática inspirada en el particular sistema visual de insectos como la langosta.

El trabajo comenzó por entender la anatomía, las respuestas y el desarrollo de los circuitos en el cerebro de una langosta, lo que les permite detectar objetos próximos y evitarlos, tanto en vuelo como en tierra.

A partir de ahí se creó lo que los investigadores denominaron sistema de control motor estimulado visualmente (VSMC, por las siglas en inglés), para la navegación autónoma de robots. El mismo consta de dos tipos de detectores de movimiento (LGMD) y un generador de comandos sencillo.

Cada detector procesa las imágenes, cubriendo una amplia parte del campo de visión, y extrae aquellas más relevantes. Estas pistas visuales se comparan y convierten después en órdenes motoras que el robot ejecuta en tiempo real.

Robots sensibles a lo que tocan

En 2010, también investigadores del MIT consiguieron dotar a los robots de otro sentido: el tacto. En colaboración con la compañía británica Peratech, en este caso los ingenieros utilizaron una tecnología consistente en unos materiales especiales que, cuando se los toca, generan una respuesta eléctrica medible y proporcional al grado de presión que se ejerza sobre ellos.

Un circuito electrónico simple instalado dentro de los robots “interpretaba” dichas señales, para que la máquina “supiese” que la están tocando y cómo.

En esta misma línea se ha trabajado también en el marco del proyecto europeo ROBOSKIN, financiado por la UE, con el desarrollo de tecnologías de sensores y una piel artificial que permitirán crear robots mucho más "sensibles" al tacto, y que tendrán por tanto relaciones más interactivas y seguras con los humanos; así como en la Viterbi School of Engineering de la University of Southern California (USC) de Estados Unidos.

En este centro, en 2013 se desarrolló una tecnología basada en sensores especiales y en un programa informático específico, que permitió crear un robot capaz de distinguir materiales solo con tocarlos, con una capacidad de acierto del 95%.

Referencia bibliográfica:

Lawson Wong, et al. Data association for semantic world modeling from partial views. International Journal of Robotics Research (2015).

Lawson Wong, et al. Data association for semantic world modeling from partial views. International Journal of Robotics Research (2015).

Tendencias Científicas

Tendencias Científicas

La Inteligencia Artificial puede ver a través del espejo

La Inteligencia Artificial puede ver a través del espejo CIENCIA ON LINE

CIENCIA ON LINE