Imagen: geralt. Fuente: Pixabay.

Funes el memorioso, personaje de Borges, recuerda todo lo que ve, hasta el más mínimo detalle, volviéndole completamente loco. Y en un episodio de la serie Black Mirror, una lentilla graba todo lo que ve la persona que la lleva puesta.

Crear algo así tiene un problema: que gasta mucha energía, pero investigadores de la Universidad Rice (Houston, Texas, EE.UU.) han resuelto ese problema, y también el de Funes: una aplicación que lo ve todo y sólo se acuerda de lo que debe.

RedEye, la nueva tecnología del Grupo de Eficiencia Computacional de Rice que se ha presentado en el Simposio Internacional de Arquitectura de Computadores (ISCA 2016), en Seúl (Corea del Sur), podría proporcionar equipos con visión continua -un primer paso para permitir que los dispositivos puedan ver lo que sus propietarios ven y hacer un seguimiento de lo que necesitan recordar.

"El concepto es permitir que nuestros ordenadores puedan ayudarnos, mostrándoles lo que vemos durante todo el día", dice el líder del grupo Lin Zhong, profesor de ingeniería eléctrica e informática en Rice y co-autor de un nuevo estudio sobre RedEye. "Sería como tener un asistente personal que le puede recordar con quién se reunió usted, dónde, lo que le dijeron y otra información específica, como precios, fechas y horas."

Zhong dice que RedEye es un ejemplo de la clase de tecnología que la industria de la computación está desarrollando para su uso con portátiles, manos libres, siempre en dispositivos que están diseñados para apoyar a las personas en su vida diaria. La tendencia, que a veces se denomina "computación ubicua" o "inteligencia ambiental", se centra en tecnología que puede reconocer e incluso anticipar lo que necesita a alguien y proporcionárselo de inmediato.

"El movimiento de computación omnipresente prevé dispositivos que sean asistentes personales, que nos ayudan de maneras grandes y pequeñas en casi todos los momentos de nuestras vidas", dice Zhong en la nota de prensa de Rice. "Sin embargo, un factor clave de esta tecnología está equipar a nuestros dispositivos para ver lo que vemos y oír lo que oímos. El olfato, el gusto y el tacto pueden venir después, pero la visión y el sonido serán las entradas sensoriales iniciales".

Zhong dice que el cuello de botella para la visión continua es el consumo de energía, porque las mejores cámaras de teléfonos inteligentes de hoy en día, aunque relativamente baratas, son asesinos de baterías, especialmente cuando procesan vídeos en tiempo real.

Zhong y el ex estudiante graduado de Rice Robert LiKamWa comenzaron a estudiar el problema en el verano de 2012, cuando trabajaban en Microsoft Research. Midieron los perfiles de energía de los sensores de imagen disponibles en el mercado y determinaron que la tecnología existente tendría que ser alrededor de 100 veces más eficiente en energía para que la visión continua se convertiera en comercialmente viable. Esta fue la motivación de la tesis doctoral de LiKamWa, que persigue un soporte de software y hardware para la visión computacional eficiente.

Crear algo así tiene un problema: que gasta mucha energía, pero investigadores de la Universidad Rice (Houston, Texas, EE.UU.) han resuelto ese problema, y también el de Funes: una aplicación que lo ve todo y sólo se acuerda de lo que debe.

RedEye, la nueva tecnología del Grupo de Eficiencia Computacional de Rice que se ha presentado en el Simposio Internacional de Arquitectura de Computadores (ISCA 2016), en Seúl (Corea del Sur), podría proporcionar equipos con visión continua -un primer paso para permitir que los dispositivos puedan ver lo que sus propietarios ven y hacer un seguimiento de lo que necesitan recordar.

"El concepto es permitir que nuestros ordenadores puedan ayudarnos, mostrándoles lo que vemos durante todo el día", dice el líder del grupo Lin Zhong, profesor de ingeniería eléctrica e informática en Rice y co-autor de un nuevo estudio sobre RedEye. "Sería como tener un asistente personal que le puede recordar con quién se reunió usted, dónde, lo que le dijeron y otra información específica, como precios, fechas y horas."

Zhong dice que RedEye es un ejemplo de la clase de tecnología que la industria de la computación está desarrollando para su uso con portátiles, manos libres, siempre en dispositivos que están diseñados para apoyar a las personas en su vida diaria. La tendencia, que a veces se denomina "computación ubicua" o "inteligencia ambiental", se centra en tecnología que puede reconocer e incluso anticipar lo que necesita a alguien y proporcionárselo de inmediato.

"El movimiento de computación omnipresente prevé dispositivos que sean asistentes personales, que nos ayudan de maneras grandes y pequeñas en casi todos los momentos de nuestras vidas", dice Zhong en la nota de prensa de Rice. "Sin embargo, un factor clave de esta tecnología está equipar a nuestros dispositivos para ver lo que vemos y oír lo que oímos. El olfato, el gusto y el tacto pueden venir después, pero la visión y el sonido serán las entradas sensoriales iniciales".

Zhong dice que el cuello de botella para la visión continua es el consumo de energía, porque las mejores cámaras de teléfonos inteligentes de hoy en día, aunque relativamente baratas, son asesinos de baterías, especialmente cuando procesan vídeos en tiempo real.

Zhong y el ex estudiante graduado de Rice Robert LiKamWa comenzaron a estudiar el problema en el verano de 2012, cuando trabajaban en Microsoft Research. Midieron los perfiles de energía de los sensores de imagen disponibles en el mercado y determinaron que la tecnología existente tendría que ser alrededor de 100 veces más eficiente en energía para que la visión continua se convertiera en comercialmente viable. Esta fue la motivación de la tesis doctoral de LiKamWa, que persigue un soporte de software y hardware para la visión computacional eficiente.

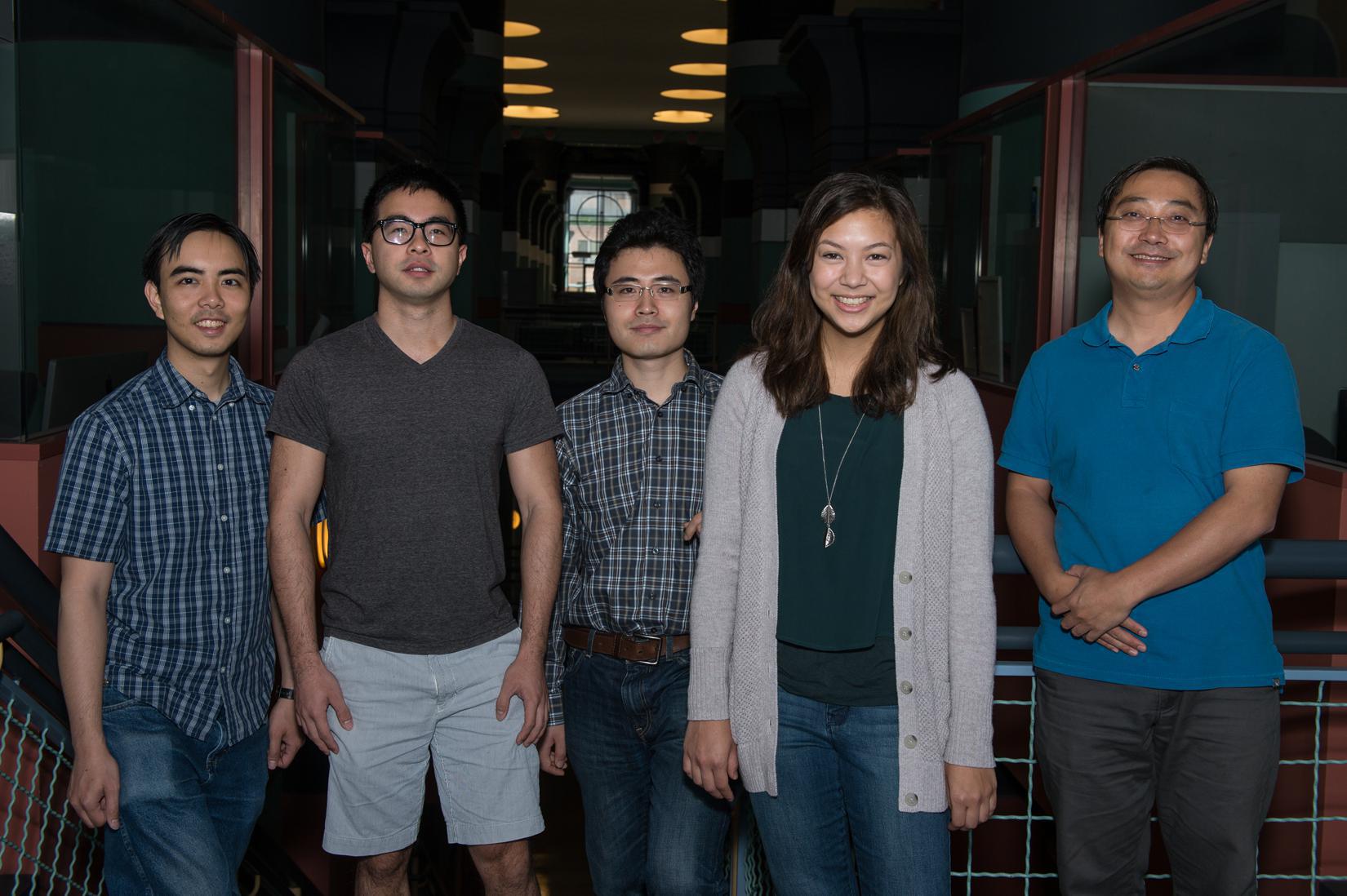

El equipo de Rice: de izda. a dcha., LiKamWa, Yuan Gao, Yunhui Hou, Mia Polansky y Zhong. Imagen: Jeff Fitlow. Fuente: Universidad Rice.

Energía

En un artículo de un año después, LiKamWa, Zhong y sus colegas demostraron que podían multiplicar por diez el consumo de energía de los sensores de imagen simplemente a través de la optimización del software.

"RedEye creció a partir de ahí porque todavía necesitábamos otra mejora de diez veces en la eficiencia energética, y sabíamos que tendríamos que rediseñar tanto el hardware como el software para lograrlo", dice LiKamWa.

El cuello de botella energético fue la conversión de imágenes de formato analógico a digital.

"Las señales del mundo real son analógicas, y su conversión en señales digitales es costosa en términos de energía", dice. "Hay un límite físico a la cantidad de ahorro de energía que se puede lograr en la conversión. Decidimos que una mejor opción podría ser la de analizar las señales cuando aún eran analógicas".

El principal inconveniente de procesar señales analógicas -y la razón de que la conversión digital sea el primer paso estándar de la mayoría de los sistemas de procesamiento de imágenes actuales- es que las señales analógicas son inherentemente ruidosas, dice LiKamWa. Para hacer RedEye atractivo para los fabricantes de dispositivos, el equipo tenía que demostrar que podía interpretar de forma fiable las señales analógicas. "Teníamos que demostrar que podíamos diferenciar un gato de un perro, por ejemplo, o una mesa de una silla".

El equipo decidió atacar el problema usando una combinación de las últimas técnicas de aprendizaje automático, arquitectura de sistemas y diseño de circuitos. En el caso del aprendizaje automático, RedEyes utiliza una técnica llamada "red neuronal de convolución," una estructura algorítmica inspirada en la organización de la corteza visual de los animales.

"El resultado es que podemos reconocer objetos -como gatos, perros, llaves, móviles, ordenadores, caras, etc.- sin tener que mirar la imagen en sí misma", dice. "Estamos mirando la salida analógica del sensor de visión. Tenemos una comprensión de lo que hay allí sin tener una imagen real. Esto aumenta la eficiencia energética, ya que podemos elegir digitalizar sólo las imágenes en las que vale la pena gastar energía."

"También puede ayudar en el tema de la privacidad, ya que podemos definir un conjunto de reglas, según las cuales el sistema descarte automáticamente la imagen en bruto después de que haya finalizado el proceso. Esa imagen no sería recuperable. Por lo tanto, si hay momentos, lugares u objetos específicos que un usuario no desea grabar -y no quiere que el sistema recuerde- debemos diseñar mecanismos para asegurar que las fotos de esas cosas ni siquiera se creen".

La investigación sobre RedEyes está en curso. El equipo está trabajando en un diseño de circuito para la arquitectura de RedEyes, que se puede utilizar para probar los problemas de diseño, falta de coincidencia de componentes, la diafonía de la señal y otros problemas de hardware. También se está trabajando para mejorar el rendimiento en entornos de poca luz y otros entornos con baja relación señal-ruido.

Ojos biónicos

Investigadores de la Universidad de Washington presentaron hace unos meses unas simulaciones visuales de lo que una persona llegaría a ver tras someterse a un implante visual. Gracias a los simuladores, los pacientes pendientes de someterse a una cirugía para recuperar la vista, podrán saber, a priori, la calidad de visión tras el implante.

En un artículo de un año después, LiKamWa, Zhong y sus colegas demostraron que podían multiplicar por diez el consumo de energía de los sensores de imagen simplemente a través de la optimización del software.

"RedEye creció a partir de ahí porque todavía necesitábamos otra mejora de diez veces en la eficiencia energética, y sabíamos que tendríamos que rediseñar tanto el hardware como el software para lograrlo", dice LiKamWa.

El cuello de botella energético fue la conversión de imágenes de formato analógico a digital.

"Las señales del mundo real son analógicas, y su conversión en señales digitales es costosa en términos de energía", dice. "Hay un límite físico a la cantidad de ahorro de energía que se puede lograr en la conversión. Decidimos que una mejor opción podría ser la de analizar las señales cuando aún eran analógicas".

El principal inconveniente de procesar señales analógicas -y la razón de que la conversión digital sea el primer paso estándar de la mayoría de los sistemas de procesamiento de imágenes actuales- es que las señales analógicas son inherentemente ruidosas, dice LiKamWa. Para hacer RedEye atractivo para los fabricantes de dispositivos, el equipo tenía que demostrar que podía interpretar de forma fiable las señales analógicas. "Teníamos que demostrar que podíamos diferenciar un gato de un perro, por ejemplo, o una mesa de una silla".

El equipo decidió atacar el problema usando una combinación de las últimas técnicas de aprendizaje automático, arquitectura de sistemas y diseño de circuitos. En el caso del aprendizaje automático, RedEyes utiliza una técnica llamada "red neuronal de convolución," una estructura algorítmica inspirada en la organización de la corteza visual de los animales.

"El resultado es que podemos reconocer objetos -como gatos, perros, llaves, móviles, ordenadores, caras, etc.- sin tener que mirar la imagen en sí misma", dice. "Estamos mirando la salida analógica del sensor de visión. Tenemos una comprensión de lo que hay allí sin tener una imagen real. Esto aumenta la eficiencia energética, ya que podemos elegir digitalizar sólo las imágenes en las que vale la pena gastar energía."

"También puede ayudar en el tema de la privacidad, ya que podemos definir un conjunto de reglas, según las cuales el sistema descarte automáticamente la imagen en bruto después de que haya finalizado el proceso. Esa imagen no sería recuperable. Por lo tanto, si hay momentos, lugares u objetos específicos que un usuario no desea grabar -y no quiere que el sistema recuerde- debemos diseñar mecanismos para asegurar que las fotos de esas cosas ni siquiera se creen".

La investigación sobre RedEyes está en curso. El equipo está trabajando en un diseño de circuito para la arquitectura de RedEyes, que se puede utilizar para probar los problemas de diseño, falta de coincidencia de componentes, la diafonía de la señal y otros problemas de hardware. También se está trabajando para mejorar el rendimiento en entornos de poca luz y otros entornos con baja relación señal-ruido.

Ojos biónicos

Investigadores de la Universidad de Washington presentaron hace unos meses unas simulaciones visuales de lo que una persona llegaría a ver tras someterse a un implante visual. Gracias a los simuladores, los pacientes pendientes de someterse a una cirugía para recuperar la vista, podrán saber, a priori, la calidad de visión tras el implante.

Referencia bibliográfica:

Robert LiKamWa, Yunhui Hou, Julian Gao, Mia Polansky, Lin Zhong: RedEye: Analog ConvNet Image Sensor Architecture for Continuous Mobile Vision. (2016).

Robert LiKamWa, Yunhui Hou, Julian Gao, Mia Polansky, Lin Zhong: RedEye: Analog ConvNet Image Sensor Architecture for Continuous Mobile Vision. (2016).