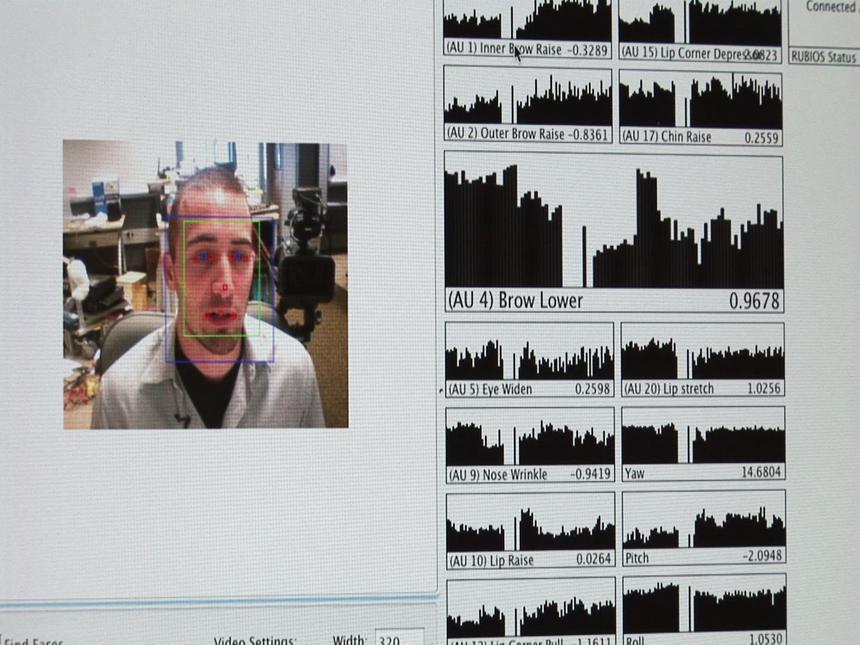

Jacob Whitehill durante la demostración. Universidad de California.

Los hallazgos presentados durante el pasado junio por el brillante joven Jacob Whitehill, que realiza actualmente sus estudios de doctorado en informática en la Escuela Jacob de Ingeniería (Universidad California, San Diego, UCSD), incluyeron una pasmosa y espectacular demostración: sin pulsar ningún botón, sin ningún mando a distancia ni cualquier otro tipo de instrumento de control en sus manos, la velocidad de reproducción de un vídeo se modulaba según sus deseos en menos tiempo del que se tarda en pronunciar la palabra PLAY gracias a las expresiones de su rostro. Es decir, en tiempo real, ya que la respuesta del aparato tiene lugar antes de que dichos deseos se conviertan en una orden.

Tal como explica la citada universidad en un comunicado, lo que hay detrás de todo ello se llama: reconocimiento de la expresión facial, y no constituye ningún misterio en el ámbito de diversas disciplinas, entre ellas la informática, la pedagogía e incluso la teoría de la evolución, que no peregrinamente viene a colación ya que fue Darwin el primero en dar cuenta de la similitud, y posible universalidad, de las expresiones no verbales en individuos de muy diferentes culturas, aunque los estudios sistemáticos concernientes a la expresión facial hubieran de esperar casi un siglo. Los llevaron a cabo Paul Ekman y Wallace Friesen.

Anatomía clásica

El hoy ya clásico Sistema de Codificación de Acción Facial (Facial Action Coding System, FACS) desarrollado por Ekman y Friesen (1978) es una de las herramientas fundamentales que Jacob Whitehill viene utilizando desde hace unos años en el desarrollo de sus experimentos y aplicaciones. Este sistema descompone la expresión facial en 46 unidades de acción (Action Unit, UA) que vienen a corresponderse aproximadamente con la actividad (y consiguiente traducción gestual) de cada uno de los músculos de la cara.

Si bien el sistema ha sido mejorado durante las últimas décadas y la cantidad de UAs ha sido ligeramente ampliada con posterioridad al trabajo de Ekman (para hacernos una idea del altísimo nivel de detalle en su descripción de expresiones basta pensar en las aproximadamente 7.000 combinaciones gestuales observadas y analizadas a partir de una base de 56 UAs), Whitehill tan sólo ha necesitado contar con el reconocimiento por visión computerizada de una docena de ellas para su estudio, si bien el equipo informático utilizado estaba dotado también de un “detector de sonrisa” y se sometieron además a observación y cuantificaron otras variables gestuales como el ritmo de pestañeo.

Captura de información

El estudio de Whitehill se enmarca dentro de un ambicioso proyecto que con toda probabilidad tendrá en un cercano futuro importantes aplicaciones pedagógicas, tanto en sistemas de tutorización inteligente como en el ámbito general de la enseñanza.

A pesar de su juventud, Whitehill cuenta ya con una amplia experiencia en el campo del diseño y la implementación de experimentos relacionados con las técnicas automatizadas de análisis gestual, de modo que la metodología y los instrumentos de los que se ha servido para llevar a cabo este estudio han contado con un considerable grado de sofisticación, especialmente en lo concerniente a la visión computerizada, el reconocimiento automatizado de patrones y el procesamiento de imagen.

Algunas de las implicaciones del desarrollo de aplicaciones relacionadas con esta investigación pueden calibrarse si se tiene en cuenta la importancia de la expresión facial como canal de información suplementario y en gran medida independiente del lenguaje oral durante los procesos de interlocución personal (y personal-maquinal). La posibilidad de capturar dicha información y la implementación de soportes adecuados para gestionarla de forma automatizada (y, lo que es especialmente relevante, hacerlo en tiempo real), es uno de los principales objetivos que Whitehill parece haberse marcado.

Enseñanza inteligente

Aunque no es difícil vislumbrar las múltiples aplicaciones que los hasta ahora fructíferos y prometedores trabajos de Whitehill podrían ofrecer sin ir más lejos a la industria del ocio (especialmente en el ámbito de los juegos interactivos), la orientación de los mismos está por su parte claramente orientada en principio al ámbito pedagógico.

Los ejes fundamentales de la aplicación (en torno a los que ha girado el estudio cuyos resultados acaban de presentarse) son dos. El primero, la evaluación automatizada del estado del oyente/lector (aburrimiento, confusión, perplejidad, interés…), y consiguientemente, el grado de dificultad (tal y como es percibida por él mismo) que está interfiriendo con su asimilación de las enseñanzas impartidas.

El segundo eje consiste en dotar a esta aplicación de la capacidad para modular automáticamente, según sus –instantáneas– preferencias, la velocidad de visionado y por tanto el volumen de flujo de contenidos. Todo ello a partir del análisis gestual computerizado.

Es obvia la relevancia de tales herramientas aplicadas a los sistemas tutoriales inteligentes, en los que cuestiones como el cuándo y el cómo enseñar, la interactividad y la retro-alimentación se consideran esenciales.

En palabras de Whitehill: Si yo fuera un estudiante que tratara con una máquina que estuviera impartiéndome una clase y me encontrara confundido, y aun así la máquina continuara inundándome con más contenido, no sería muy útil para mí. En cambio, si ante mi estado de confusión la máquina se detuviera un momento y dijera: ‘Vaya!, quizá estés algo confuso…”, y yo le respondiera: ‘Sí, gracias por darme un respiro’, entonces todo sería estupendo.

La esponsorización de su estudio por parte, entre otras instituciones, del Temporal Dynamics of Learning Center (de la UCSD) parece indicar que el joven Jacob Whitehill no va a estar solo a la hora de desarrollar estos proyectos desde luego estupendos.

Tal como explica la citada universidad en un comunicado, lo que hay detrás de todo ello se llama: reconocimiento de la expresión facial, y no constituye ningún misterio en el ámbito de diversas disciplinas, entre ellas la informática, la pedagogía e incluso la teoría de la evolución, que no peregrinamente viene a colación ya que fue Darwin el primero en dar cuenta de la similitud, y posible universalidad, de las expresiones no verbales en individuos de muy diferentes culturas, aunque los estudios sistemáticos concernientes a la expresión facial hubieran de esperar casi un siglo. Los llevaron a cabo Paul Ekman y Wallace Friesen.

Anatomía clásica

El hoy ya clásico Sistema de Codificación de Acción Facial (Facial Action Coding System, FACS) desarrollado por Ekman y Friesen (1978) es una de las herramientas fundamentales que Jacob Whitehill viene utilizando desde hace unos años en el desarrollo de sus experimentos y aplicaciones. Este sistema descompone la expresión facial en 46 unidades de acción (Action Unit, UA) que vienen a corresponderse aproximadamente con la actividad (y consiguiente traducción gestual) de cada uno de los músculos de la cara.

Si bien el sistema ha sido mejorado durante las últimas décadas y la cantidad de UAs ha sido ligeramente ampliada con posterioridad al trabajo de Ekman (para hacernos una idea del altísimo nivel de detalle en su descripción de expresiones basta pensar en las aproximadamente 7.000 combinaciones gestuales observadas y analizadas a partir de una base de 56 UAs), Whitehill tan sólo ha necesitado contar con el reconocimiento por visión computerizada de una docena de ellas para su estudio, si bien el equipo informático utilizado estaba dotado también de un “detector de sonrisa” y se sometieron además a observación y cuantificaron otras variables gestuales como el ritmo de pestañeo.

Captura de información

El estudio de Whitehill se enmarca dentro de un ambicioso proyecto que con toda probabilidad tendrá en un cercano futuro importantes aplicaciones pedagógicas, tanto en sistemas de tutorización inteligente como en el ámbito general de la enseñanza.

A pesar de su juventud, Whitehill cuenta ya con una amplia experiencia en el campo del diseño y la implementación de experimentos relacionados con las técnicas automatizadas de análisis gestual, de modo que la metodología y los instrumentos de los que se ha servido para llevar a cabo este estudio han contado con un considerable grado de sofisticación, especialmente en lo concerniente a la visión computerizada, el reconocimiento automatizado de patrones y el procesamiento de imagen.

Algunas de las implicaciones del desarrollo de aplicaciones relacionadas con esta investigación pueden calibrarse si se tiene en cuenta la importancia de la expresión facial como canal de información suplementario y en gran medida independiente del lenguaje oral durante los procesos de interlocución personal (y personal-maquinal). La posibilidad de capturar dicha información y la implementación de soportes adecuados para gestionarla de forma automatizada (y, lo que es especialmente relevante, hacerlo en tiempo real), es uno de los principales objetivos que Whitehill parece haberse marcado.

Enseñanza inteligente

Aunque no es difícil vislumbrar las múltiples aplicaciones que los hasta ahora fructíferos y prometedores trabajos de Whitehill podrían ofrecer sin ir más lejos a la industria del ocio (especialmente en el ámbito de los juegos interactivos), la orientación de los mismos está por su parte claramente orientada en principio al ámbito pedagógico.

Los ejes fundamentales de la aplicación (en torno a los que ha girado el estudio cuyos resultados acaban de presentarse) son dos. El primero, la evaluación automatizada del estado del oyente/lector (aburrimiento, confusión, perplejidad, interés…), y consiguientemente, el grado de dificultad (tal y como es percibida por él mismo) que está interfiriendo con su asimilación de las enseñanzas impartidas.

El segundo eje consiste en dotar a esta aplicación de la capacidad para modular automáticamente, según sus –instantáneas– preferencias, la velocidad de visionado y por tanto el volumen de flujo de contenidos. Todo ello a partir del análisis gestual computerizado.

Es obvia la relevancia de tales herramientas aplicadas a los sistemas tutoriales inteligentes, en los que cuestiones como el cuándo y el cómo enseñar, la interactividad y la retro-alimentación se consideran esenciales.

En palabras de Whitehill: Si yo fuera un estudiante que tratara con una máquina que estuviera impartiéndome una clase y me encontrara confundido, y aun así la máquina continuara inundándome con más contenido, no sería muy útil para mí. En cambio, si ante mi estado de confusión la máquina se detuviera un momento y dijera: ‘Vaya!, quizá estés algo confuso…”, y yo le respondiera: ‘Sí, gracias por darme un respiro’, entonces todo sería estupendo.

La esponsorización de su estudio por parte, entre otras instituciones, del Temporal Dynamics of Learning Center (de la UCSD) parece indicar que el joven Jacob Whitehill no va a estar solo a la hora de desarrollar estos proyectos desde luego estupendos.