los ordenadores te conocen mejor que tu familia http://www.sciencedaily.com/releases/2015/01/150112154456.htm

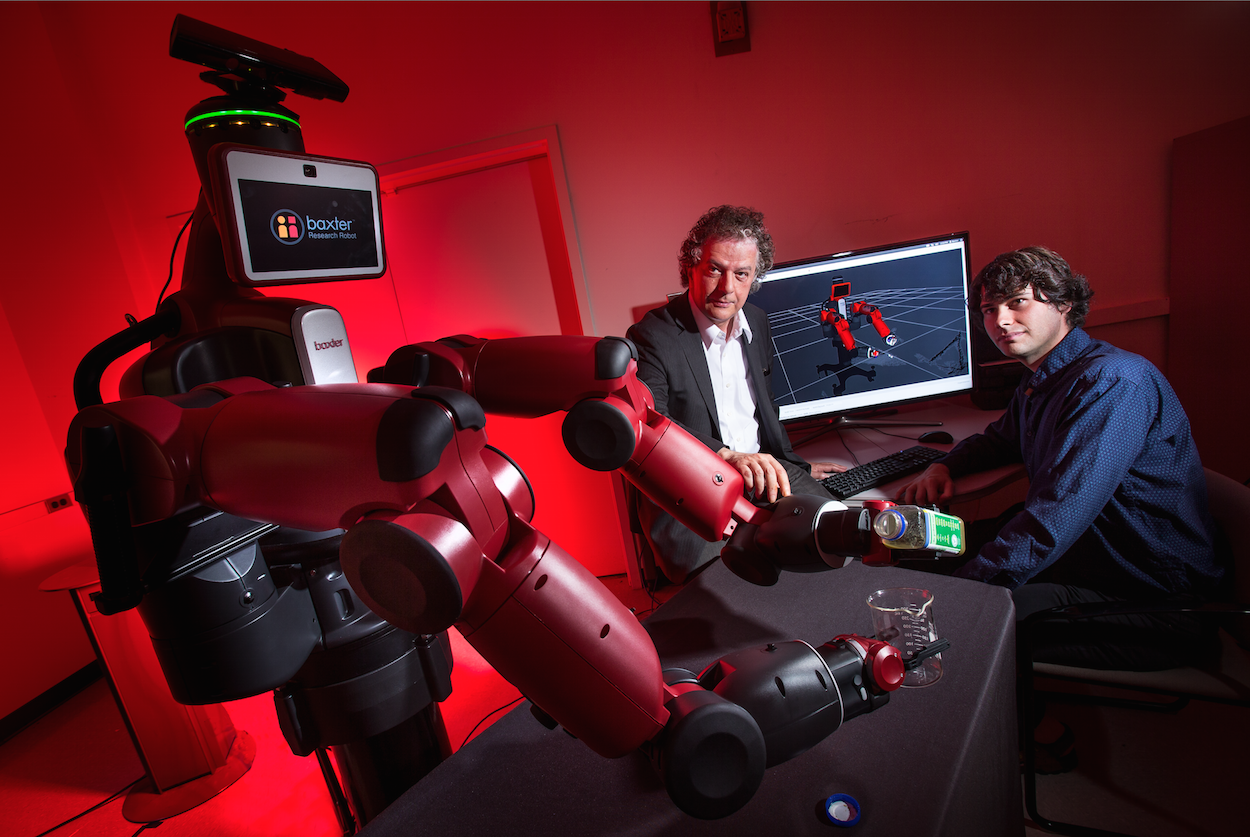

Hace unos días hablamos del desarrollo, por parte de investigadores del Instituto Tecnológico de Massachusettes (MIT, EEUU) de un algoritmo que permite a los robots domésticos reconocer objetos rápidamente.

Ahora, hemos sabido de otro avance, en este caso realizado por investigadores del Instituto de Estudios Computacionales Avanzados de la Universidad de Maryland (UMIACS), también en EEUU, que hará posible que los robots aprendan a cocinar viendo vídeos en YouTube. La combinación de ambas técnicas mejoraría sin duda la interacción de los humanos con estas máquinas.

Robots pensantes

“Imagine tener un robot personal que le prepare el desayuno cada mañana. E imagine que ese robot no necesita ninguna ayuda para averiguar cómo hacer una tortilla perfecta, porque lo ha aprendido viendo videos en YouTube”, se explica en la página web de la Universidad de Maryland.

Luego se especifica: más concretamente, lo que los robots serán capaces de aprender, a partir del visionado de imágenes y gracias a la nueva tecnología, serán los intrincados movimientos de manipulación requeridos para cocinar.

Todo gracias a que estarán dotados de "pensamiento". Este les permitirá determinar la mejor combinación de acciones para realizar eficientemente una tarea dada.

Ahora, hemos sabido de otro avance, en este caso realizado por investigadores del Instituto de Estudios Computacionales Avanzados de la Universidad de Maryland (UMIACS), también en EEUU, que hará posible que los robots aprendan a cocinar viendo vídeos en YouTube. La combinación de ambas técnicas mejoraría sin duda la interacción de los humanos con estas máquinas.

Robots pensantes

“Imagine tener un robot personal que le prepare el desayuno cada mañana. E imagine que ese robot no necesita ninguna ayuda para averiguar cómo hacer una tortilla perfecta, porque lo ha aprendido viendo videos en YouTube”, se explica en la página web de la Universidad de Maryland.

Luego se especifica: más concretamente, lo que los robots serán capaces de aprender, a partir del visionado de imágenes y gracias a la nueva tecnología, serán los intrincados movimientos de manipulación requeridos para cocinar.

Todo gracias a que estarán dotados de "pensamiento". Este les permitirá determinar la mejor combinación de acciones para realizar eficientemente una tarea dada.

Máquinas que se ocupen de las tareas cotidianas

Para conseguir esto, los especialistas combinaron métodos de tres áreas distintas de investigación: la inteligencia artificial (o diseño de ordenadores que puedan tomar sus propias decisiones); la visión computacional (de esto iba el estudio del MIT antes mencionado: ingeniería de sistemas que puedan identificar de manera exacta formas y movimientos); y el procesamiento del lenguaje natural (o desarrollo de sistemas artificiales que comprendan órdenes habladas).

Asimismo, se basaron en una arquitectura de software especializada y conocida como redes neurales de aprendizaje profundo, que intenta imitar la actividad de las distintas capas de neuronas en la corteza cerebral para reconocer patrones en representaciones digitales de sonidos, imágenes y otros datos.

Versiones similares de redes neuronales son hoy por hoy responsables, por ejemplo, de las capacidades de reconocimiento de voz de los smartphones o de los programas informáticos de reconocimiento facial.

El objetivo final de todo este esfuerzo tecnológico es generar robots que interactúen con los humanos de manera “natural”. Los científicos de la Universidad de Maryland sueñan ya con un futuro en el que estas máquinas se ocupen de las tareas cotidianas y dejen libres a los humanos para tareas más estimulantes.

Para conseguir esto, los especialistas combinaron métodos de tres áreas distintas de investigación: la inteligencia artificial (o diseño de ordenadores que puedan tomar sus propias decisiones); la visión computacional (de esto iba el estudio del MIT antes mencionado: ingeniería de sistemas que puedan identificar de manera exacta formas y movimientos); y el procesamiento del lenguaje natural (o desarrollo de sistemas artificiales que comprendan órdenes habladas).

Asimismo, se basaron en una arquitectura de software especializada y conocida como redes neurales de aprendizaje profundo, que intenta imitar la actividad de las distintas capas de neuronas en la corteza cerebral para reconocer patrones en representaciones digitales de sonidos, imágenes y otros datos.

Versiones similares de redes neuronales son hoy por hoy responsables, por ejemplo, de las capacidades de reconocimiento de voz de los smartphones o de los programas informáticos de reconocimiento facial.

El objetivo final de todo este esfuerzo tecnológico es generar robots que interactúen con los humanos de manera “natural”. Los científicos de la Universidad de Maryland sueñan ya con un futuro en el que estas máquinas se ocupen de las tareas cotidianas y dejen libres a los humanos para tareas más estimulantes.

Referencia bibliográfica:

Yezhou Yang, Yi Li, Cornelia Fermüller y Yiannis Aloimonos presentarán su estudio Robot Learning Manipulation Action Plans by ‘Watching’ Unconstrained Videos from the World Wide Web el próximo 29 de enero en Austin (Texas), en la Conferencia de la Association for the Advancement of Artificial Intelligence.

Yezhou Yang, Yi Li, Cornelia Fermüller y Yiannis Aloimonos presentarán su estudio Robot Learning Manipulation Action Plans by ‘Watching’ Unconstrained Videos from the World Wide Web el próximo 29 de enero en Austin (Texas), en la Conferencia de la Association for the Advancement of Artificial Intelligence.